Der Textgenerator ChatGPT ist derzeit in allen Medien. Jede Zeitung und jedes Online-Portal probiert aus, nimmt Stellung, vergleicht Maschinentexte mit menschlichen Texten. ChatGPT ist in seiner Art faszinierend, weckt aber auch Ängste. Möglicherweise geht es ja um nicht weniger als um ein Element auf dem Weg, den Menschen und seine Denkleistungen überflüssig zu machen. Um einen Zynismus gleich vorneweg zu stellen: Auch das würde auf eine Marktsättigung hinauslaufen. Es ist nämlich unwahrscheinlich, dass im Endzustand dann vereinsamte Chat-Roboter ihre Texte gegenseitig lesen würden. Und zwischenmaschinelle Liebesbriefe in einer entmenschlichten Umgebung wären ohnehin nicht die Stärke des Systems, wie etliche Testnutzer herausgefunden haben.

Der Textgenerator ChatGPT ist derzeit in allen Medien. Jede Zeitung und jedes Online-Portal probiert aus, nimmt Stellung, vergleicht Maschinentexte mit menschlichen Texten. ChatGPT ist in seiner Art faszinierend, weckt aber auch Ängste. Möglicherweise geht es ja um nicht weniger als um ein Element auf dem Weg, den Menschen und seine Denkleistungen überflüssig zu machen. Um einen Zynismus gleich vorneweg zu stellen: Auch das würde auf eine Marktsättigung hinauslaufen. Es ist nämlich unwahrscheinlich, dass im Endzustand dann vereinsamte Chat-Roboter ihre Texte gegenseitig lesen würden. Und zwischenmaschinelle Liebesbriefe in einer entmenschlichten Umgebung wären ohnehin nicht die Stärke des Systems, wie etliche Testnutzer herausgefunden haben.

Sie sehen schon, dieser Text entstammt noch rein biologischen Hirnwindungen. Zu der vorgenannten Parabel wäre ChatGPT derzeit und wohl auch noch länger nicht bereit. Was kann es aber? Auch wir konnten der Versuchung eines Selbsttests nicht widerstehen. Das Ergebnis entspricht dem, was viele andere Tester auch herausgefunden haben. Bei recht konkreten Wissensfragen kommen ebenfalls recht konkrete Antworten, also, für eine Hausarbeit in Schule oder Hochschule wären die Textergebnisse bei bescheidenen Ansprüchen und bei Hinzugabe einiger eigener Absätze und Gedanken schon ohne weiteres verwendbar. Das für sich genommen ist bereits ein Thema, mit dem sich alle Bildungsträger auseinandersetzen müssen. Es wird auch kaum noch möglich sein, Robo-Texte mit „herkömmlichen“ Plagiatsprüfungen zu erkennen, dazu sind sie zu beliebig und werden ja scheinbar individuell erzeugt, finden sich also in dieser genauen Form nicht in Publikationen.

Der Dialog erfolgt in Chat-Form, so heißt das Ding ja. Man gibt Fragen ein, es blinkt ein simulierter Text-Cursor, und nach einigen Sekunden Wartezeit klimpert der Text zeichenweise über den Bildschirm wie bei einem alten Fernschreiber. Das soll wohl den Anschein erwecken, als säße auf der anderen Seite der Leitung eine Person mit zwei bis zehn Fingern. Fast immer kommt zunächst ein einleitender, meist wenig bis nichts sagender Satz. Viele Antworten kommen in drei Textblöcken wie ein Mini-Aufsatz mit Einleitung, Hauptteil, Schluss.

Jeder Tester möchte ja irgendeine Grenze des Systems finden, beispielsweise herausfinden, ob das System quasi über sich selbst nachdenken kann, also zu einer Art Selbstreflexion fähig ist. So direkt wird man das nicht fragen, wir haben uns herangetastet mit:

Frage: Wie würden Menschen denken, die zu ihrer Bildung nur Texte aus einem Chatbot lesen könnten?

ChatGPT Antwort (Auszug): „Es ist schwierig, zu sagen, wie Menschen denken würden, die ausschließlich Texte aus einem Chatbot lesen würden, da es von vielen Faktoren abhängt, wie zum Beispiel ihrem Bildungsniveau, ihren Interessen und Erfahrungen. Wenn Menschen ausschließlich Texte aus einem Chatbot zur Verfügung hätten, um sich zu bilden, würde dies wahrscheinlich sowohl Vor- als auch Nachteile mit sich bringen.“

Das ist Kaugummitext, so schreibt ein Oberstufenschüler, der von dem gefragten Thema keine Ahnung hat. Ein wenig spezifischer wird es dann schon noch, aber begrenzt. Wir wollten es genauer wissen und haben die Frage dann so gestellt:

Frage: Stelle dir vor, Menschen würden wie in Platons Höhlengleichnis nur Texte von ChatGPT lesen, niemals in ihrem Leben etwas Anderes. Wie würden diese Menschen sein?

ChatGPT Antwort: „Wenn Menschen ihr ganzes Leben lang nur Texte von ChatGPT lesen würden, könnten sie sich in einer ähnlichen Situation befinden wie die Gefangenen in Platons Höhlengleichnis. Sie könnten davon ausgehen, dass die Texte, die sie lesen, die einzige Wahrheit sind und dass es keine anderen Perspektiven gibt. Dies könnte zu einem sehr begrenzten Verständnis der Welt führen, das auf den Antworten und Informationen beschränkt ist, die von ChatGPT bereitgestellt werden.

Da ChatGPT ein AI-System ist, das auf Machine Learning-Algorithmen basiert, könnte es möglicherweise auch eine begrenzte menschliche Perspektive auf die Welt haben. Das System könnte darauf trainiert sein, auf bestimmte Fragen oder Themen zu antworten, aber es könnte Schwierigkeiten haben, menschliche Emotionen oder komplexe menschliche Verhaltensweisen zu verstehen. Dadurch könnten die Menschen, die nur Texte von ChatGPT lesen, ein eingeschränktes Verständnis der menschlichen Natur und der menschlichen Erfahrung haben.

Da ChatGPT ein AI-System ist, das auf Machine Learning-Algorithmen basiert, könnte es möglicherweise auch eine begrenzte menschliche Perspektive auf die Welt haben. Das System könnte darauf trainiert sein, auf bestimmte Fragen oder Themen zu antworten, aber es könnte Schwierigkeiten haben, menschliche Emotionen oder komplexe menschliche Verhaltensweisen zu verstehen. Dadurch könnten die Menschen, die nur Texte von ChatGPT lesen, ein eingeschränktes Verständnis der menschlichen Natur und der menschlichen Erfahrung haben.

Insgesamt könnten Menschen, die ihr ganzes Leben lang nur Texte von ChatGPT lesen, möglicherweise Schwierigkeiten haben, komplexe Zusammenhänge zu verstehen und menschliche Interaktionen effektiv zu navigieren. Sie könnten auch eine begrenzte Vorstellungskraft und Kreativität haben, da ChatGPT möglicherweise nicht in der Lage ist, die menschliche Kreativität vollständig zu erfassen. Letztendlich könnte dies zu einer eingeschränkten, begrenzten und möglicherweise sogar isolierten Perspektive auf die Welt führen.“

Also, Platons Höhlengleichnis kennt das System schon mal und interpretiert die Frage grundsätzlich richtig. Die Gefahr einer einseitigen Informationsvermittlung, die die Frage ausloten möchte, umschifft das System aber nur mühsam. Sie scheint durch, wird jedoch in Konjunktiven ertränkt. Dennoch: Alle Achtung!

Damit fällt ein erheblicher Unterschied zu Vorläufern dieser KI-Lösung auf, namentlich zu einem kaum noch bekannten System, das Microsoft 2016 als Test herausbrachte, den Tay Bot. Dieses System war ein Twitter-Bot und lernte wohl überwiegend aus anderen Twitter-Nachrichten. Innerhalb eines Tages kippte die Sache um, die Tweets wurden rassistisch, sexistisch und noch mehr. ChatGPT schreibt zu diesem Risiko auf der Startseite den netten Satz „may produce biased content“. Systeme dieser Art müssen ja unendlich Zeug reinsaugen wie ein Wal das Plankton. Darin sind immer auch Giftstoffe enthalten. Die hatten sich in kürzester Zeit im Textmagen angereichert. Auch einer zweiten Lösung ging es so, sie musste innerhalb eines Tages vom Netz. Die ZEIT beschrieb damals in einem Artikel sogar, das Programm befürworte Völkermord. Das beste und auch heute noch gültige Zitat ist indes: Ein solches System sei ein Roboter-Papagei mit Internetverbindung.

Der Roboter-Papagei folgt Regeln, hängt letztlich an Fäden wie eine Marionette. Auf diese Fäden und ihre Führer kommt es an, sie sind die Programmierung durch den „Meister“ obendrüber. Bei ChatGPT merkt der sprachlich Einfühlsame, dass die Regelparameter auf Deeskalation gesetzt sind. Das System erkennt Fallen, greift zunehmend zum Konjunktiv und geht schnell über zu einem deutlichen ethischen Haftungsausschluss. Wer wie der Autor Technik studiert hat, insbesondere Regelungstechnik, liest quasi im übermittelten Text den Programmcode als Untertitel mit. So weit, so gut. Die Deeskalation funktioniert. Die Räder könnten aber auch jederzeit anders eingestellt werden, denn sie sind vorhanden und klar beschriftet.

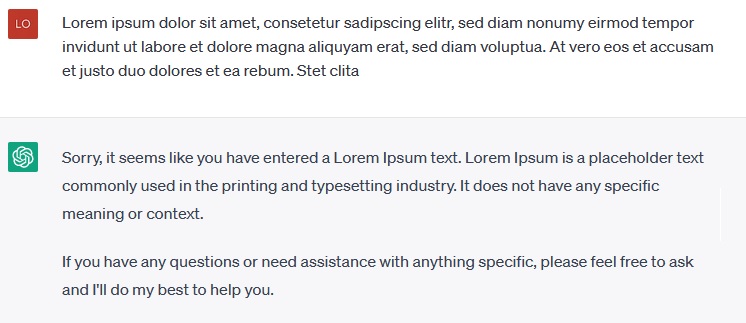

ChatGPT erkennt auch unsinnige Anfragen und antwortet höflich

Damit stehen wir da, wo jede Technik steht. Sie ist zum Guten und zum Schlechten einsetzbar. Mit den nun verfügbaren Textgeneratoren besteht auch ein mächtiges Werkzeug für destruktives Handeln. Eine Handvoll Personen kann tausende von Fake-Accounts in den sozialen Medien betreiben und eigentlich stabil geglaubte gesellschaftliche Positionen mit ständig wechselnden, scheinvernünftig ausgedachten Texten unterspülen. Das fördert sehr schnell Totalitarismus und gefährdet Demokratie, so unmissverständlich muss man es sagen. Ein hartes „zurück zum menschlichen Handeln“ in jeder Form, also funktional wie inhaltlich, durch Nutzeridentifikation wie durch Inhaltsprüfung, wird immer zwingender in den Netzen und Medien. Sonst werden die Ausgänge von Wahlen beliebig manipulierbar und Kriege beinahe auch, wenn man dazu nicht noch etwas Hardware bräuchte.

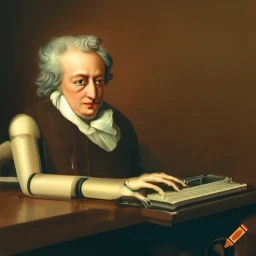

Aufgabe an einen KI Bildgenerator: „ChatGPT sitzt vor der Tastatur, schreibt Antworten und sieht aus wie Johann Wolfgang v. Goethe“. Der künstliche Arm ist ein witziges Ergebnis.

Um diesen Beitrag lustig zu beenden, hier eine letzte Frage an ChatGPT. Es ging uns um Energieerzeugung, Tiere, alte Technik: Was weiß das System und wie ist sein Bewertungsverhalten eingestellt?

Frage: Lohnt es sich, mit einem Eselgöpel Energie zu erzeugen?

ChatGPT Antwort: Die Verwendung eines Eselgöpels zur Energieerzeugung kann je nach den Umständen und Anforderungen unterschiedlich rentabel sein. Eselgöpel wurden traditionell verwendet, um Energie in landwirtschaftlichen und handwerklichen Betrieben zu erzeugen, insbesondere um Getreide zu mahlen oder Wasser aus Brunnen zu ziehen.

Heutzutage gibt es jedoch in der Regel effizientere und kostengünstigere Methoden zur Energieerzeugung, wie z.B. Elektrizität aus dem Stromnetz oder Solar- oder Windenergie. Wenn Sie jedoch in einer abgelegenen Gegend leben, wo keine Stromversorgung vorhanden ist, kann ein Eselgöpel eine sinnvolle Option sein.

Es ist auch wichtig zu bedenken, dass die Verwendung von Tieren zur Energieerzeugung ethische Bedenken aufwerfen kann und eine gewisse Menge an Pflege und Wartung erfordert. Wenn Sie jedoch an historischer Handwerkskunst interessiert sind oder einfach nur einen alternativen Ansatz zur Energieerzeugung ausprobieren möchten, kann die Verwendung eines Eselgöpels eine interessante Option sein.

Was ist nun das Ergebnis? Die Angst vor dem System als solchem haben wir verloren, die Möglichkeiten und Grenzen sind erkennbar. Die schlechte Vision ist, dass jeder Computernutzer ungeachtet seiner Absichten nun über eine nicht versiegende Textquelle verfügt, die einer oder einem wenig Schreibbegabten das Formulieren erleichtert, die aber auch als Vielzweck-Brandbeschleuniger in jede Richtung genutzt werden kann. Vor allem die politische Dimension macht uns hier Sorgen.

(Hinweis: Das Titelbild wurde automatisch erzeugt mit dem KI-Bildgenerator Pixlr X. Der Goethe mit dem künstlichen Arm mit dem KI-Bildgenerator Craiyon. Beide hatten auf englisch die Aufgabe bekommen, „ChatGPT sitzt vor dem Computer und tippt in die Tastatur, sieht aus wie Goethe“.)